La inteligencia artificial dejó de ser una promesa y se convirtió en una palanca operativa y estratégica para las áreas de administración y finanzas. En este artículo encontrarás las 10 tecnologías de IA más relevantes para empresas, ejemplos concretos de herramientas en uso y un enfoque práctico para su adopción, con especial atención a cómo impactan procesos, gobernanza y talento.

1. Modelos de lenguaje e IA generativa para reporting y comunicación

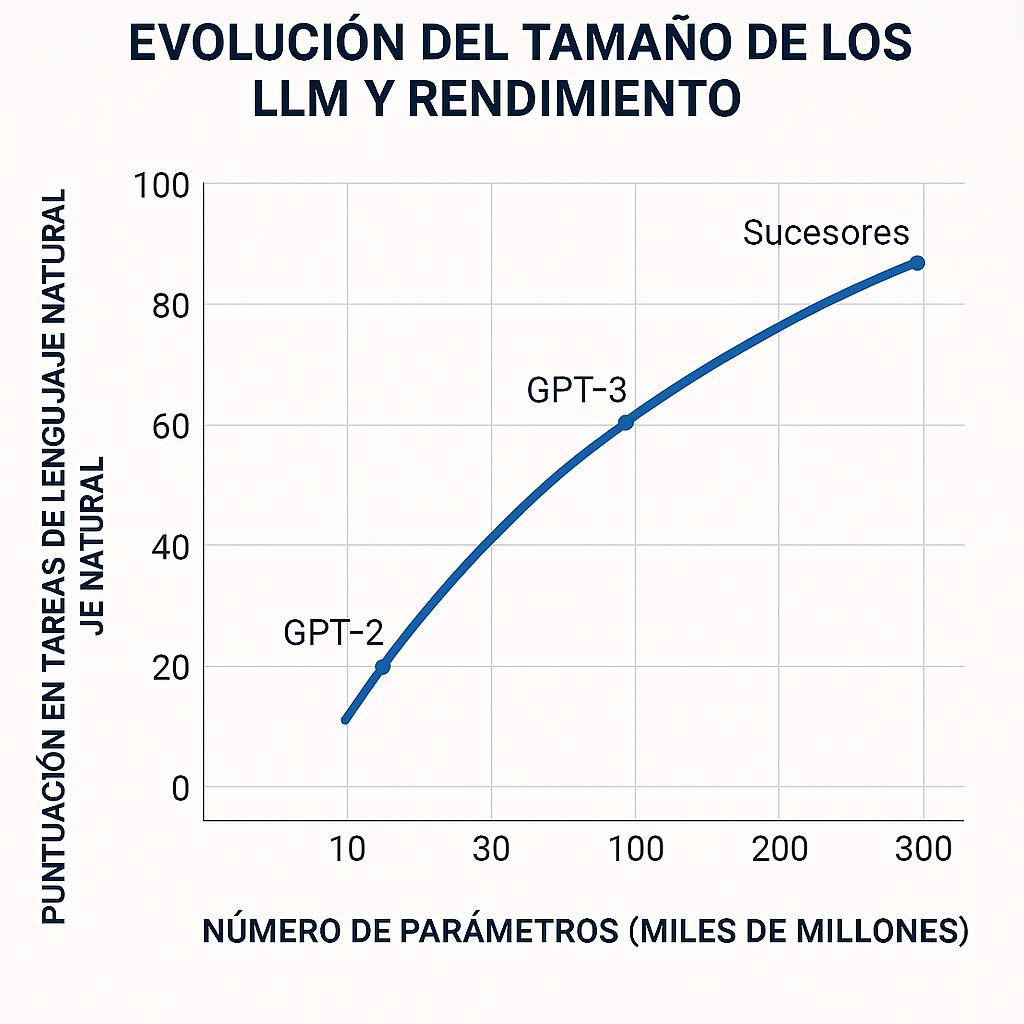

Los modelos de lenguaje automatizan la redacción de informes, explicaciones de variaciones y borradores de presentaciones a partir de datos financieros. En administración, esto reduce el tiempo de preparación de reportes mensuales y mejora la consistencia de la comunicación interna y hacia directorios.

Ejemplos: OpenAI (ChatGPT/GPT); Anthropic Claude.

2. Plataformas FP&A con capacidades predictivas

Estas plataformas unifican datos operativos y financieros, permiten simulaciones “what‑if” y generan forecasts automáticos con ML. Son clave para acortar ciclos de planificación y mejorar la precisión presupuestaria.

Ejemplos: Anaplan; Workday Adaptive Planning.

3. Procesamiento inteligente de documentos (OCR + NLP)

Combinan OCR avanzado con NLP para extraer, validar y clasificar datos de facturas, contratos y comprobantes. Reducen errores manuales y aceleran cuentas por pagar/por cobrar y cierres contables.

Ejemplos: ABBYY FlexiCapture; UiPath Document Understanding.

4. RPA potenciado por IA para operaciones repetitivas

Los robots de software automatizan conciliaciones, cargas y validaciones, y usan modelos para gestionar excepciones. Esto libera al equipo financiero de tareas operativas y reduce tiempos de cierre.

Ejemplos: UiPath; Automation Anywhere.

5. Analítica predictiva y forecasting avanzado

Modelos estadísticos y de machine learning pronostican ventas, demanda y flujo de caja incorporando variables externas. Permiten decisiones proactivas sobre tesorería y capital de trabajo.

Ejemplos: DataRobot; H2O.ai..

6. Detección de anomalías y prevención de fraude

Sistemas que monitorean transacciones en tiempo real para identificar patrones atípicos y generar alertas tempranas. Fortalecen controles internos y reducen pérdidas por fraude. Ejemplos: Feedzai; Forter.

7. Conectores y plataformas de datos financieros

Herramientas que agregan y normalizan datos desde bancos, ERPs y servicios externos, habilitando reporting en tiempo real y conciliaciones automáticas. Son la base para decisiones basadas en datos frescos.

Ejemplos: Fivetran; Plaid.

8. Agentes y copilotos financieros

Asistentes conversacionales integrados con sistemas financieros que responden consultas, generan KPIs y preparan borradores analíticos. Mejoran la accesibilidad de la información para CFOs y equipos. Ejemplos: Microsoft Copilot for Finance; BloombergGPT.

9. Gobernanza, explicabilidad y cumplimiento de modelos

Herramientas y marcos que proveen trazabilidad, métricas de sesgo y auditoría de modelos en producción. Son imprescindibles para cumplir regulaciones y garantizar confianza en decisiones automatizadas.

Ejemplos: Fiddler AI; ModelOp.

10. Modelos multimodales para visión y texto

Modelos que procesan imágenes y texto simultáneamente para validar facturas escaneadas, extraer cláusulas contractuales y automatizar revisiones documentales. Aceleran auditorías y revisiones legales-financieras.

Ejemplos: Google Gemini; GPT‑4o Vision.

Cómo priorizar la adopción en tu organización

- Diagnóstico operativo: Mapear procesos repetitivos y cuellos de botella en cierre, conciliaciones y reporting.

- Pilotos de alto ROI: Empezar por procesamiento de facturas, conciliaciones automáticas y forecasting de cashflow.

- Gobernanza desde el inicio: Definir políticas de datos, controles de calidad y un comité de IA con finanzas, TI, legal y auditoría interna.

- Medición y KPIs: Establecer métricas claras: reducción del tiempo de cierre, % de facturas automatizadas, precisión del forecast y reducción de errores.

Impacto en empleo y profesionalización

La adopción de IA en administración y finanzas transforma roles más que los elimina. Las tareas repetitivas (entrada de datos, conciliaciones básicas, generación de borradores) tienden a automatizarse, mientras que emergen perfiles de mayor valor: analistas de datos financieros, gestores de modelos, especialistas en gobernanza y estrategas financieros. El éxito depende de un plan de upskilling que combine formación técnica con gestión del cambio.

Veredicto: la IA puede reducir la carga operativa y ciertos puestos administrativos tradicionales, pero simultáneamente eleva el nivel profesional requerido en los equipos financieros. Las organizaciones que acompañen automatización con capacitación y rediseño de roles obtendrán mayor productividad y mejores decisiones.